ollama大模型不安装在C盘,在其他盘的教程

最近DeepSeek很热门,各位都是想在自己的电脑做个兴趣部署学习,但ollama默认只装在C盘,导致在拉取大模型的时候C盘爆满,今天来教大家用命令模式专在C盘以外的磁盘上

马上开干:

第一步:首先是下载ollama软件 https://www.ollama.com/download 点击下载适合你电脑的版本,本次我们是以win系统为例,下载win版本,有些伙伴网速不好下载不了,可以在评论区留言

在win系统一般下载后就双击安装,但是ollama双击安装的话会默认在C盘,所以我们下载后先不要安装,后面我们用命令行来安装,先把下载的安装文件拷贝到D盘或者其他盘,新建个ollama的文件夹,一会方便找到

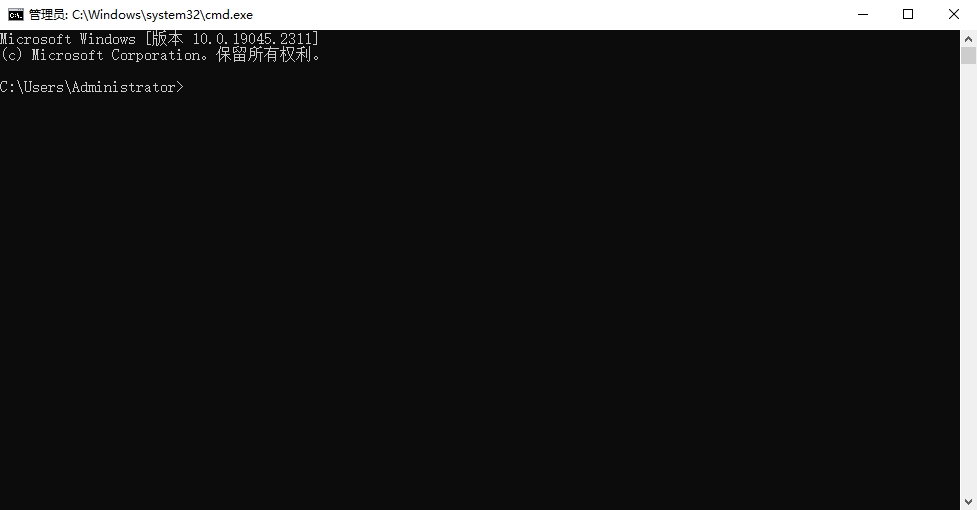

第二步:WIN+R打开运行框,然后输入CMD,打开终端,记住,一定要管理员身份运行

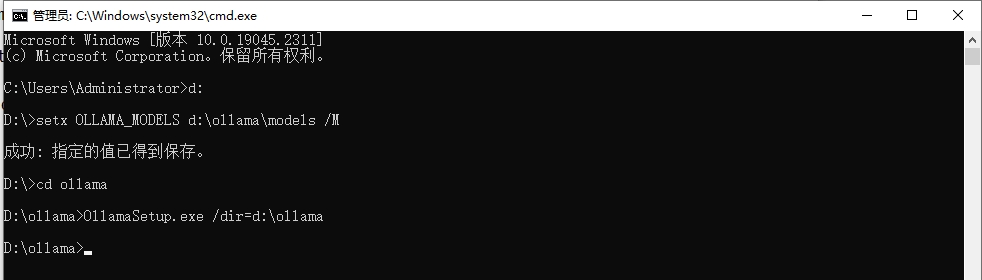

然后 在光标 输入 d:切换在底盘的命令行

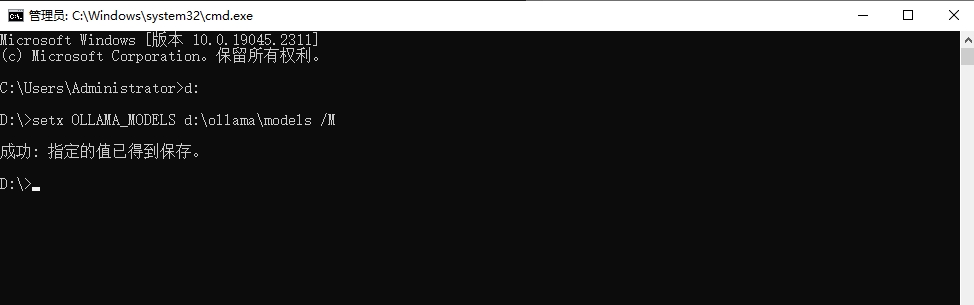

紧接着用命令创建系统环境变量:

setx OLLAMA_MODELS d:\ollama\models /M

这里我们看到环境变量已经保存(注意环境变量名要全大写的,M是代表全系统环境的变量)

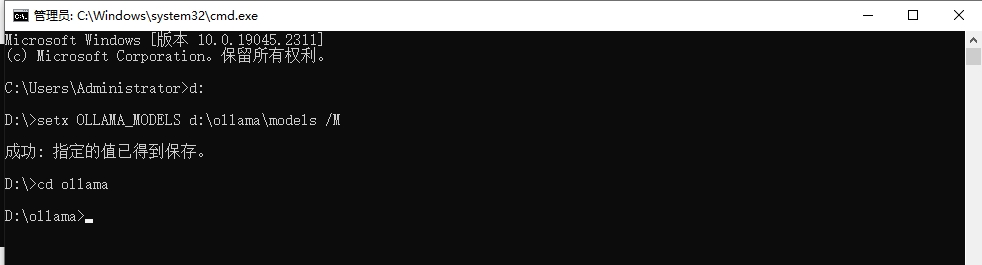

接下来我们让命令行进入刚才创建ollama的文件夹 cd ollama

然后就是安装了,全面说不要双击安装,我们来命令安装

OllamaSetup.exe /dir=d:\ollama

OllamaSetup.exe 就是安装文件的名称 /dir=d:\ollama /dir到d盘的ollama 这里就是制定安装的目录,到这里我们就上面命令然后回车

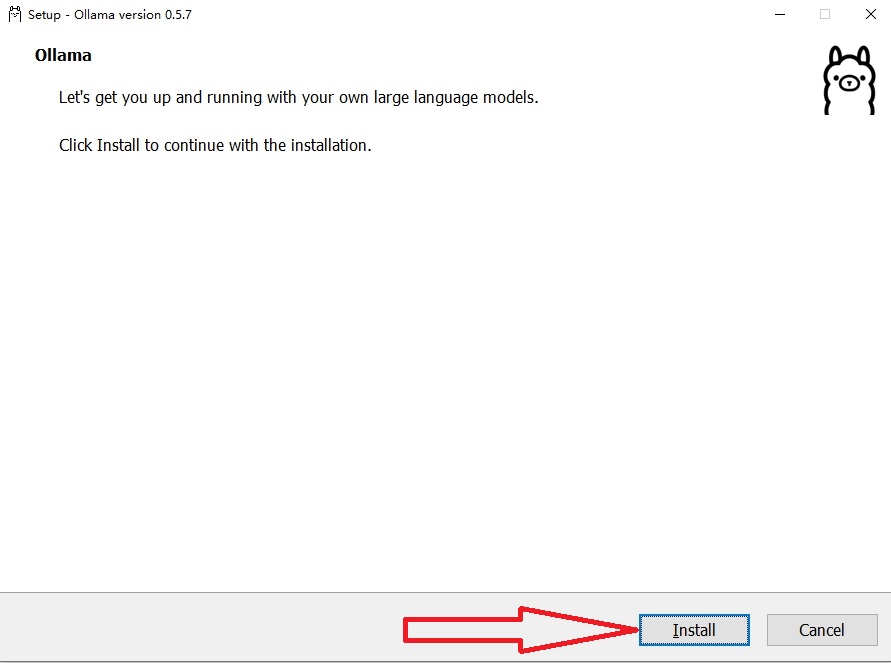

回车后,安装页面就会弹出来

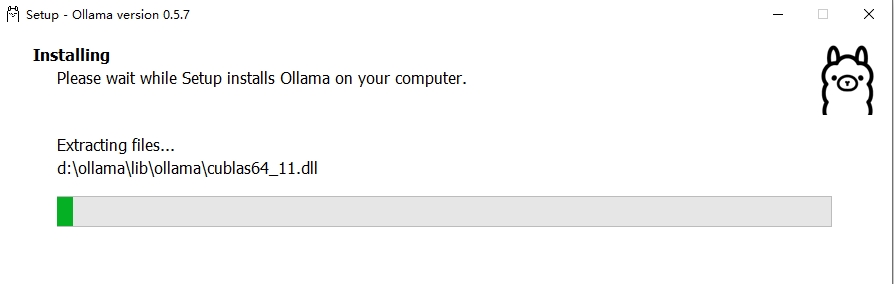

我们直接点安装就行,然后等待安装就是,安装的过程中你能看到把文件安装到D盘了

等待安装成功后在任务栏就会出现ollama的小图标了

这个时候我们再回到CMD命令行,来验证ollama安装是否成功

在命令行输入ollama -v 如果出现版本号,代表安装已经成功

这个时候我们就可以到ollama官网找匹配的模型进行拉取,拉取的模型也会默认放在D盘了